Heisenberg había presentado su propio modelo de átomo renunciando a todo intento de describir el átomo como un compuesto de partículas y ondas. Pensó que estaba condenado al fracaso cualquier intento de establecer analogías entre la estructura atómica y la estructura del mundo. Prefirió describir los niveles de energía u órbitas de electrones en términos numéricos puros, sin la menor traza de esquemas. Como quiera que usó un artificio matemático denominado “matriz” para manipular sus números, el sistema se denominó “mecánica de matriz”.

Heisenberg recibió el premio Nobel de Física en 1932 por sus aportaciones a la mecánica ondulatoria de Schrödinger, pues esta última pareció tan útil como las abstracciones de Heisenberg, y siempre es difícil, incluso para un físico, desistir de representar gráficamente las propias ideas.

Una vez presentada la mecánica matriz (para dar otro salto atrás en el tiempo) Heisenberg pasó a considerar un segundo problema: cómo describir la posición de la partícula. ¿Cuál es el procedimiento indicado para determinar dónde está una partícula? La respuesta obvia es ésta: observarla. Pues bien, imaginemos un microscopio que pueda hacer visible un electrón. Si lo queremos ver debemos proyectar una luz o alguna especie de radiación apropiada sobre él. Pero un electrón es tan pequeño, que bastaría un solo fotón de luz para hacerle cambiar de posición apenas lo tocara. Y en el preciso instante de medir su posición, alteraríamos ésta.

Aquí nuestro artificio medidor es por lo menos tan grande como el objeto que medimos; y no existe ningún agente medidor más pequeño que el electrón. En consecuencia, nuestra medición debe surtir, sin duda, un efecto nada desdeñable, un efecto más bien decisivo en el objeto medido. Podríamos detener el electrón y determinar así su posición en un momento dado. Pero si lo hiciéramos, no sabríamos cuál es su movimiento ni su velocidad. Por otra parte, podríamos gobernar su velocidad, pero entonces no podríamos fijar su posición en un momento dado.

Heisenberg demostró que no nos será posible idear un método para localizar la posición de la partícula subatómica mientras no estemos dispuestos a aceptar la incertidumbre absoluta respecto a su posición exacta. Es un imposible calcular ambos datos con exactitud al mismo tiempo.

Siendo así, no podrá haber una ausencia completa de energía ni en el cero absoluto siquiera. Si la energía alcanzara el punto cero y las partículas quedaran totalmente inmóviles, sólo sería necesario determinar su posición, puesto que la velocidad equivaldría a cero. Por tanto, sería de esperar que subsistiera alguna “energía residual del punto cero”, incluso en el cero absoluto, para mantener las partículas en movimiento y también, por así decirlo, nuestra incertidumbre. Esa energía “punto cero” es lo que no se puede eliminar, lo que basta para mantener liquido el helio incluso en el cero absoluto.

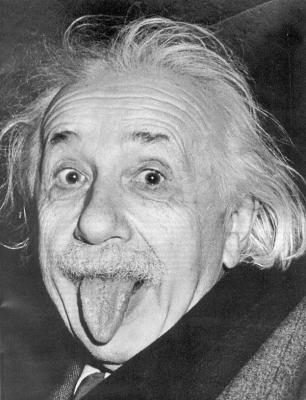

En 1930, Einstein demostró que el principio de incertidumbre (donde se afirma la imposibilidad de reducir el error en la posición sin incrementar el error en el momento) implicaba también la imposibilidad de reducir el error en la medición de energía sin acrecentar la incertidumbre del tiempo durante el cual se toma la medida. Él creyó poder utilizar esta tesis como trampolín para refutar el principio de incertidumbre, pero Bohr procedió a demostrar que la refutación tentativa de Einstein era errónea.

A decir verdad, la versión de la incertidumbre, según Einstein, resultó ser muy útil, pues significó que en un proceso subatómico se podía violar durante breves lapsos la ley sobre conservación de energía siempre y cuando se hiciese volver todo al estado de conservación cuando concluyesen esos períodos: cuanto mayor sea la desviación de la conservación, tanto más breves serán los intervalos de tiempo tolerables. Yukawa aprovechó esta noción para elaborar su teoría de los piones. Incluso posibilitó la elucidación de ciertos fenómenos subatómicos presuponiendo que las partículas nacían de la nada como un reto a la energía de conservación, pero se extinguían antes del tiempo asignado a su detección, por lo cual eran sólo “partículas virtuales”. Hacia fines de la década 1940-1950, tres hombres elaboraron la teoría sobre esas partículas virtuales: fueron los físicos norteamericanos Julian Schwinger y Richard Phillips Feynman y el físico japonés Sin-itiro Tomonaga. Para recompensar ese trabajo, se les concedió a los tres el premio Nobel de Física en 1965.

A partir de 1976 se han producido especulaciones acerca de que el Universo comenzó con una pequeña pero muy masiva partícula virtual que se expandió con extrema rapidez y que aún sigue existiendo. Según este punto de vista, el Universo se formó de la Nada y podemos preguntarnos acerca de la posibilidad de que haya un número infinito de Universos que se formen (y llegado el momento acaben) en un volumen infinito de Nada.

El “principio de incertidumbre” afectó profundamente al pensamiento de los físicos y los filósofos. Ejerció una influencia directa sobre la cuestión filosófica de “casualidad” (es decir, la relación de causa y efecto). Pero sus implicaciones para la ciencia no son las que se suponen por lo común. Se lee a menudo que el principio de incertidumbre anula toda certeza acerca de la naturaleza y muestra que, al fin y al cabo, la ciencia no sabe ni sabrá nunca hacia dónde se dirige, que el conocimiento científico está a merced de los caprichos imprevisibles de un Universo donde el efecto no sigue necesariamente a la causa. Tanto si esta interpretación es válida desde el ángulo visual filosófico como si no, el principio de incertidumbre no ha conmovido la actitud del científico ante la investigación. Si, por ejemplo, no se puede predecir con certeza el comportamiento de las moléculas individuales en un gas, también es cierto que las moléculas suelen acatar ciertas leyes, y su conducta es previsible sobre una base estadística, tal como las compañías aseguradoras calculan con índices de mortalidad fiables, aunque sea imposible predecir cuándo morirá un individuo determinado.

Ciertamente, en muchas observaciones científicas, la incertidumbre es tan insignificante comparada con la escala correspondiente de medidas, que se la puede descartar para todos los propósitos prácticos. Uno puede determinar simultáneamente la posición y el movimiento de una estrella, o un planeta, o una bola de billar, e incluso un grano de arena con exactitud absolutamente satisfactoria.

Respecto a la incertidumbre entre las propias partículas subatómicas, cabe decir que no representa un obstáculo, sino una verdadera ayuda para los físicos. Se la ha empleado para esclarecer hechos sobre la radiactividad, sobre la absorción de partículas subatómicas por los núcleos, así como otros muchos acontecimientos subatómicos, con mucha más racionabilidad de lo que hubiera sido posible sin el principio de incertidumbre.

El principio de incertidumbre significa que el Universo es más complejo de lo que se suponía, pero no irracional.

(SACADO DE http://mipagina.cantv.net/aquilesr/principio_incertidumbre.htm)

![S = int left[ frac{c^4}{16 pi G} , R + L_mathrm{M} right] sqrt{-g} , d^4x](http://terrinches.blogia.com/upload/externo-6b778c5bf13f66f0addd5161af373d70.png)